NVIDIA AI Day Tokyoに参加しました

2025/9/25に、東京ミッドタウンで開催された、NVIDIA AI Day Tokyoに参加してきました。

招待制で900 名ほどの参加者が集まったセッション中心のイベントで、そこまで人数が多くなかったため、登壇者に質問したり、NVIDIA社員の方とコミュニケーションを取れたりと、 より深く学べる 有意義なイベントでした。

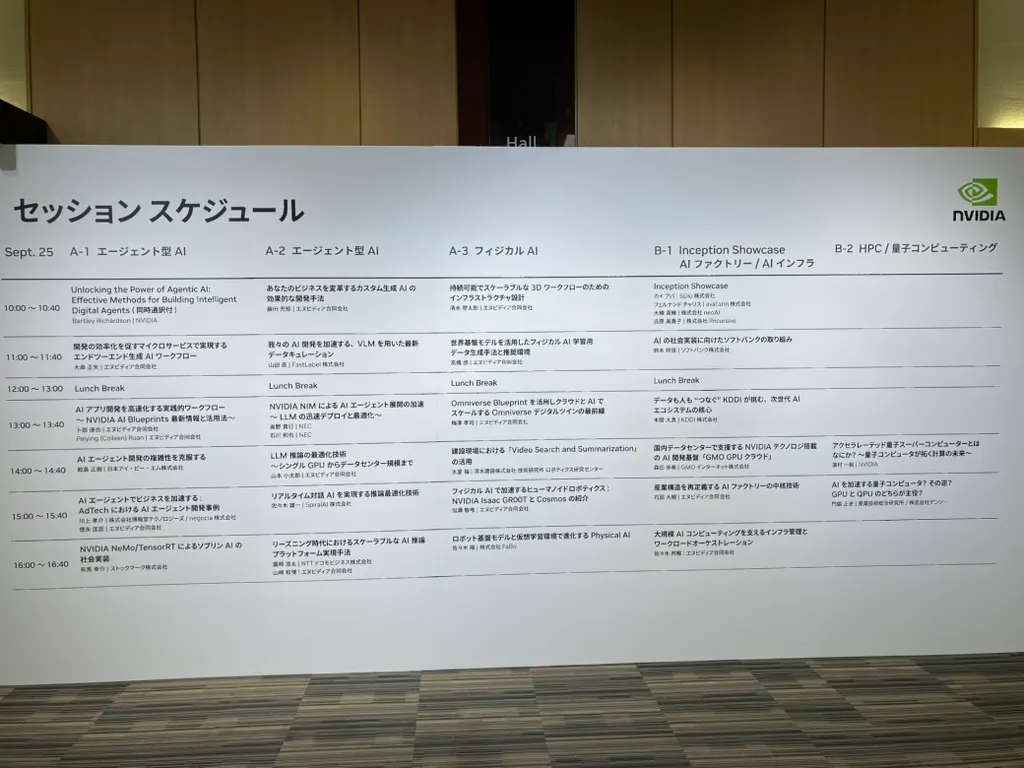

セッション会場は、エージェント型AI、フィジカルAI、 AIファクトリー / AIインフラ、HPC / 量子コンピューティングといった分野で分かれていました。エージェント型AIは2会場で行われていました!

この記事では、特に気になったセッションについて紹介したいと思います。

世界基盤モデルを活用したフィジカル AI 学習用データ生成手法と推奨環境

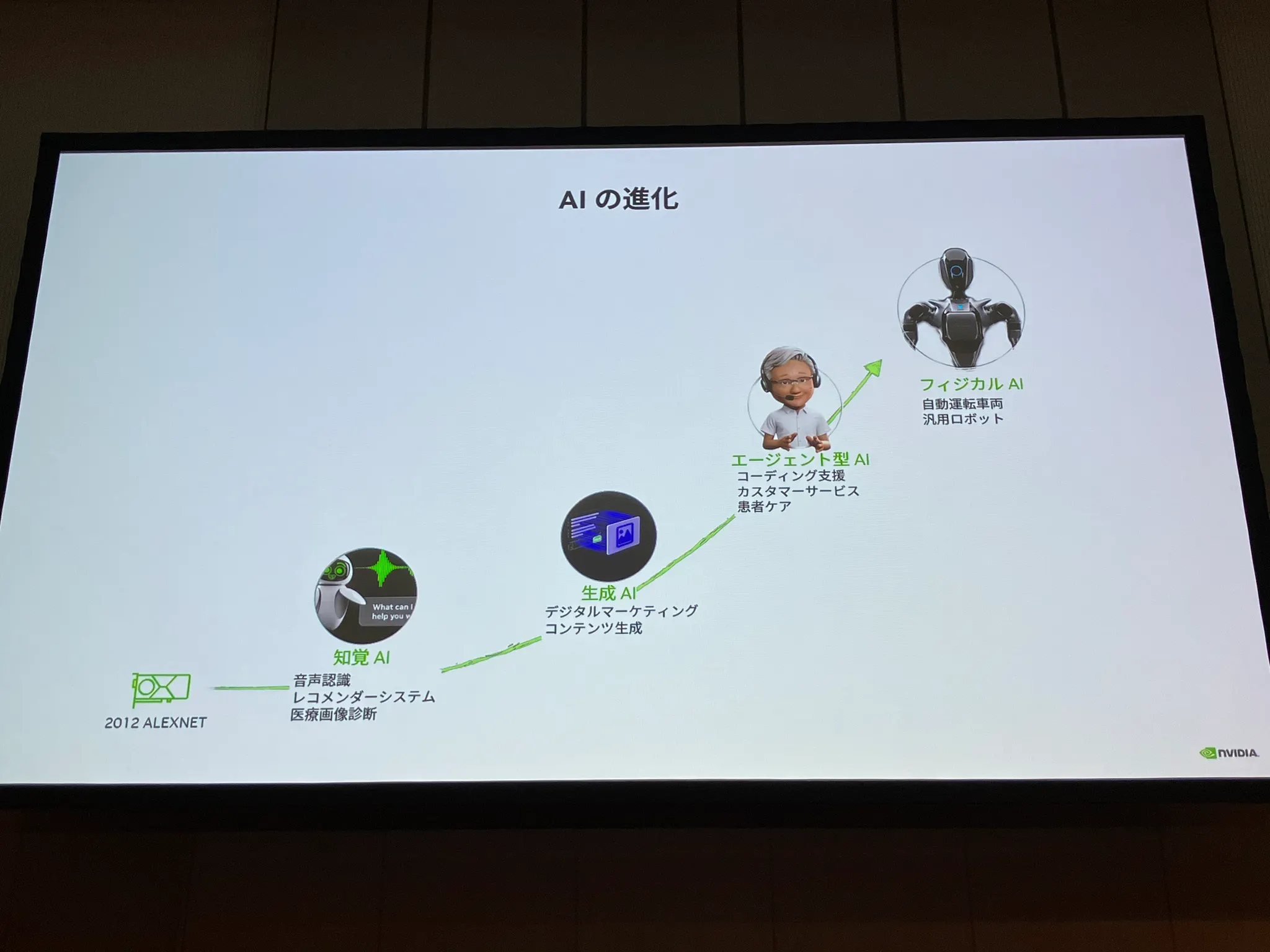

フィジカルAIは、ロボットや自動運転車が、物理的な世界を認識して複雑な行動ができるようになる技術で、生成AI・エージェントAI に続く 、次に来るAIと言われています ✨

他のセッションにも、よくこのスライドが登場していました。AIの進化のイメージです。

物理世界での複雑な行動が求められる フィジカルAIですが、物理環境を学習するためには、圧倒的に学習データが足りていないという問題があります。

それを解決するため、デジタルツイン構築プラットフォーム NVIDIA Omniverse 上で動く、 NVIDIA Cosmos と Isaac GR00T という技術が使われています。

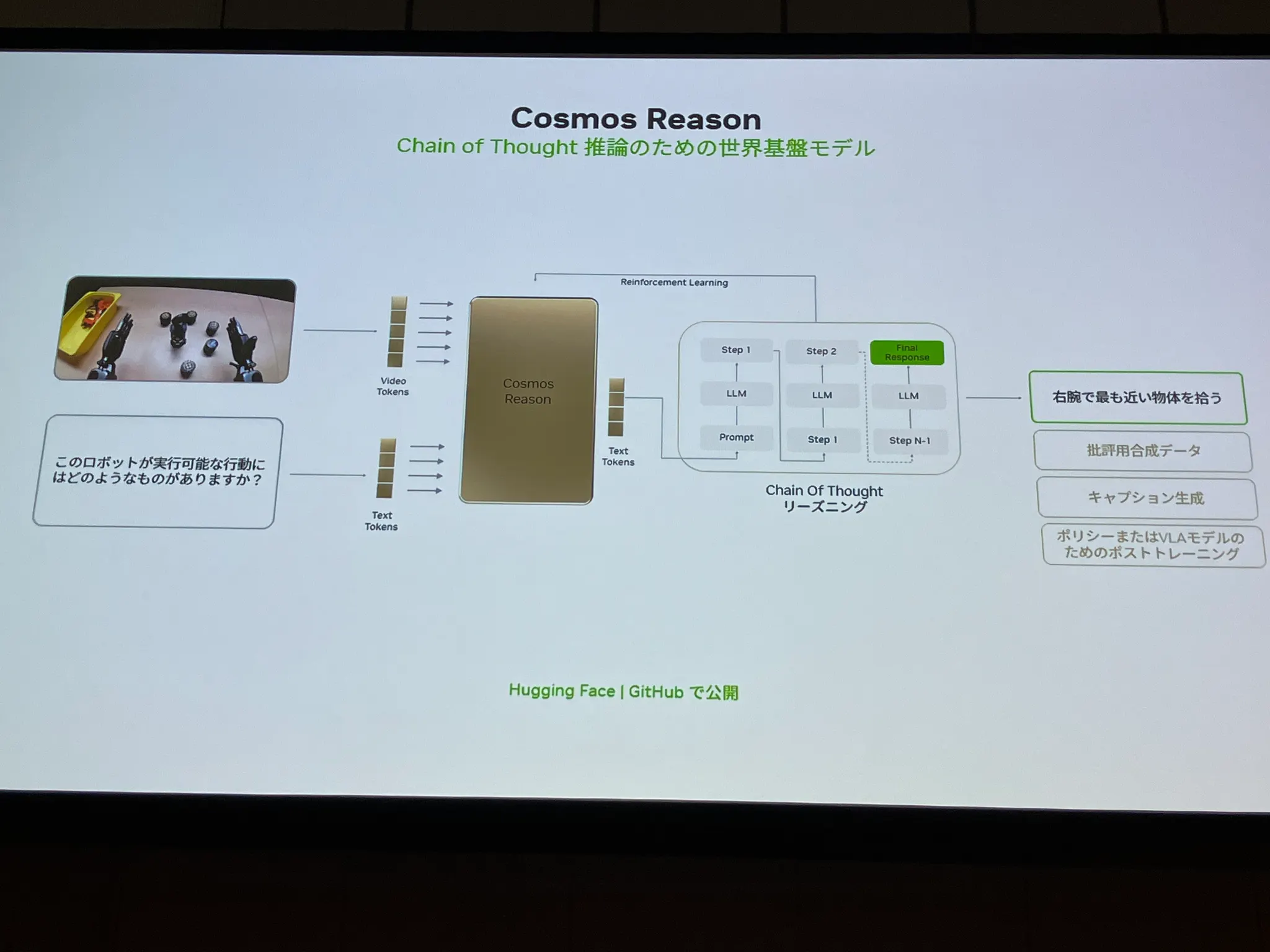

世界基盤モデルであるNVIDIA Cosmosは、Cosmos Reasonという技術を提供しており、動画や画像を入力として、物理世界を理解することができます。

ヒューマノイド向けAIやロボットの開発基盤 Isaac GR00T のためのワークフローの紹介です。

まず、 人間がVRゴーグルを装着して10回動作を行うと、 それを基に、Omniverseと連携し、背景や光の当たり方を変えた 100万種類もの多様な学習データを自動で作成できる といった仕組みです 。

実際にリアルな世界でこれをやろうとすると、かなりコストがかかりますし、危険なデータ収集も安全なデジタルツイン上でできるというのが強みですね。

フィジカルAI、なんとなく聞いたことがあるなというぐらいだったのですが、学習データ生成の大変さと、それをシミュレーション技術で解決しようとするNVIDIAの強さを実感したセッションでした 💪🏻

AI エージェントでビジネスを加速する:AdTech における AI エージェント開発事例

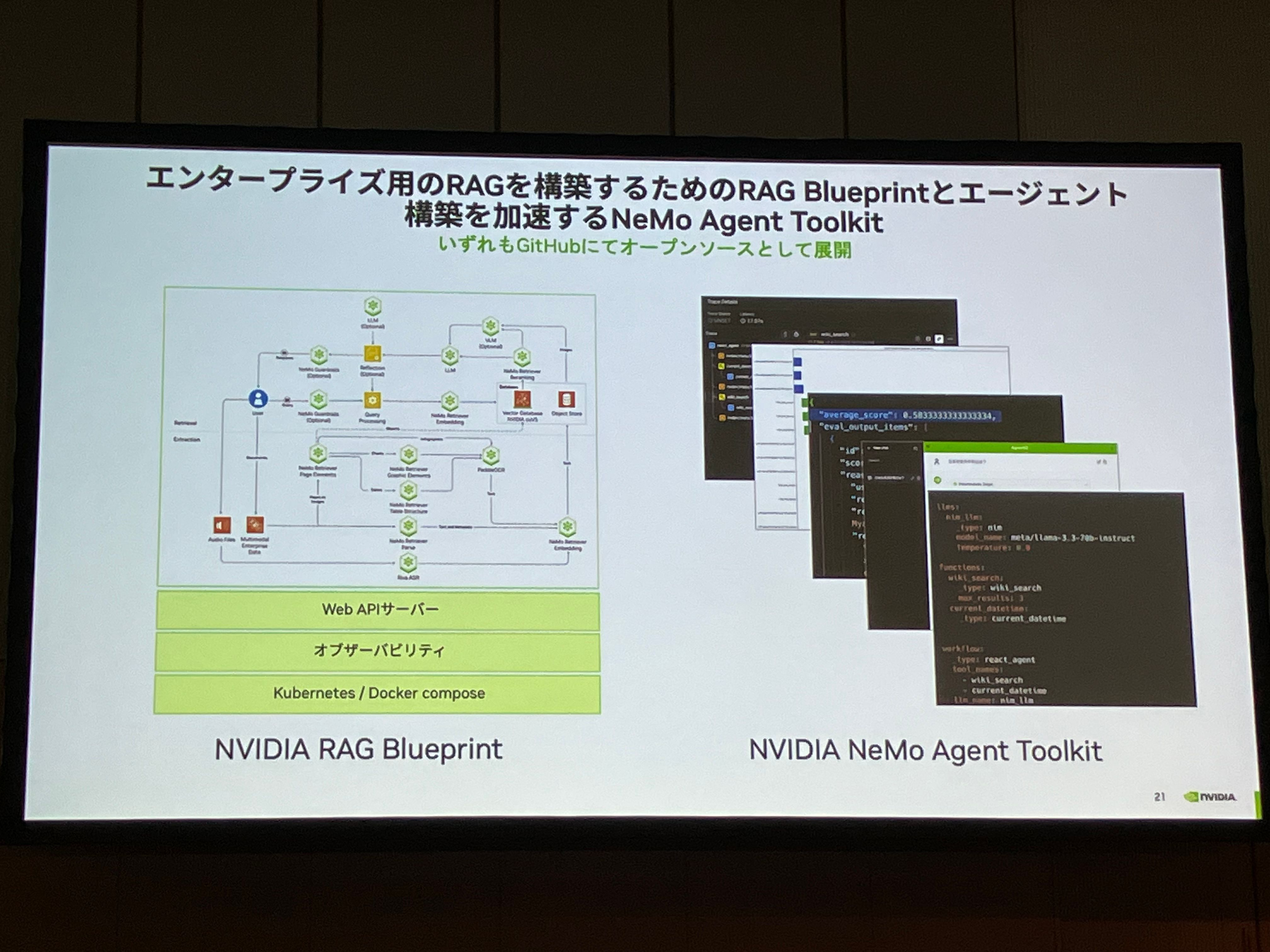

エンタープライズに必要な要素(デプロイ方法やオブザーバビリティの組み込み方など)が揃ったRAGを開発できる RAG Blueprint と、エージェント型AIを簡単に開発できる NeMo Agent Toolkit 。

このセッションは、これらの2つの技術についてのNVIDIAによる解説、そしてそれらを活用している博報堂テクノロジーズの事例紹介で構成されていました。

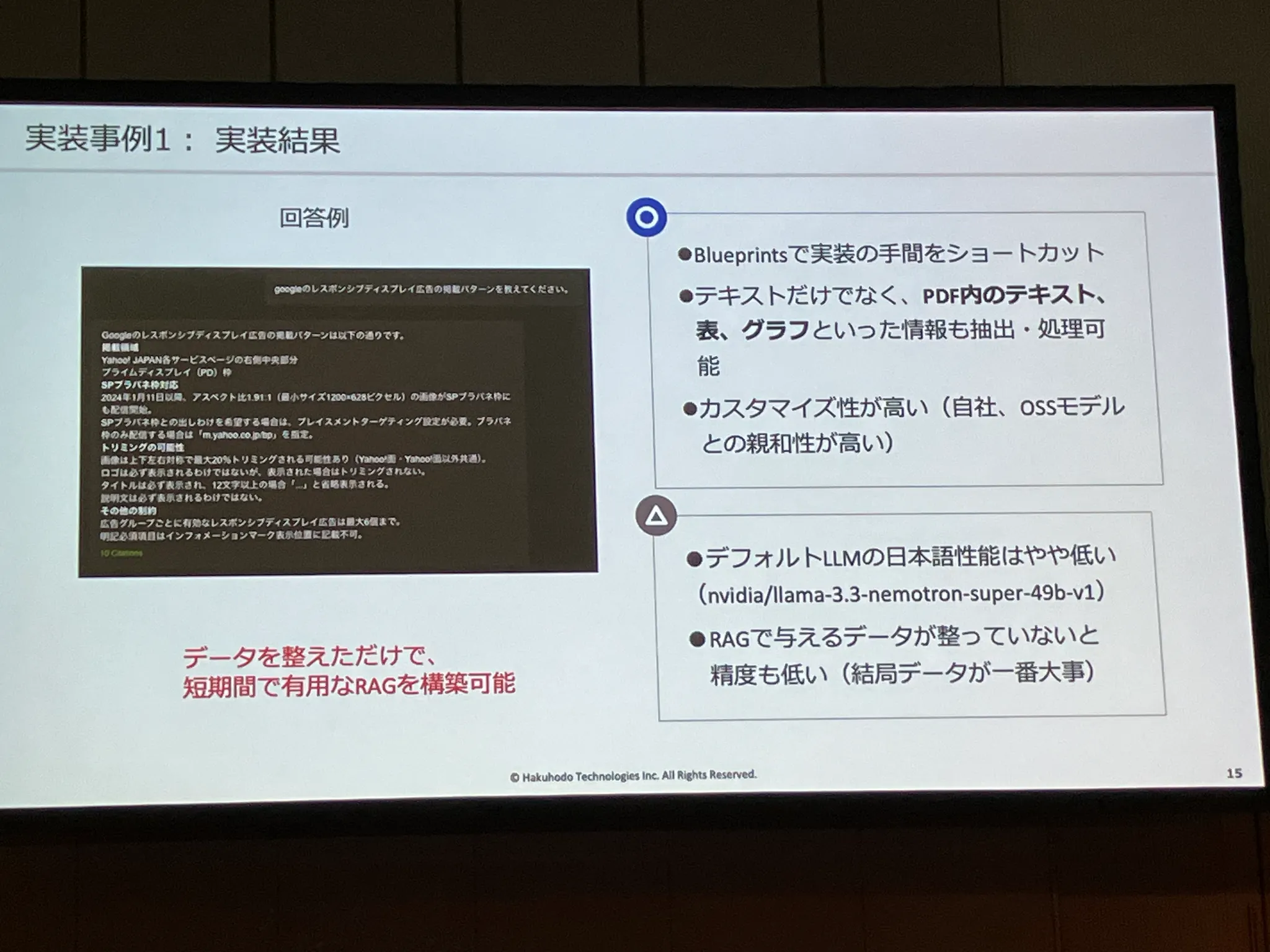

博報堂テクノロジーズは、RAG Blueprint を用いて、各プラットフォームの広告に関する規定確認や用語解説を行うサービスを構築しています。

ファイル保存先に、多くのノウハウが入っている社内資料を格納するのみで、以下のように、業務で有用なRAGの構築ができたそうです。

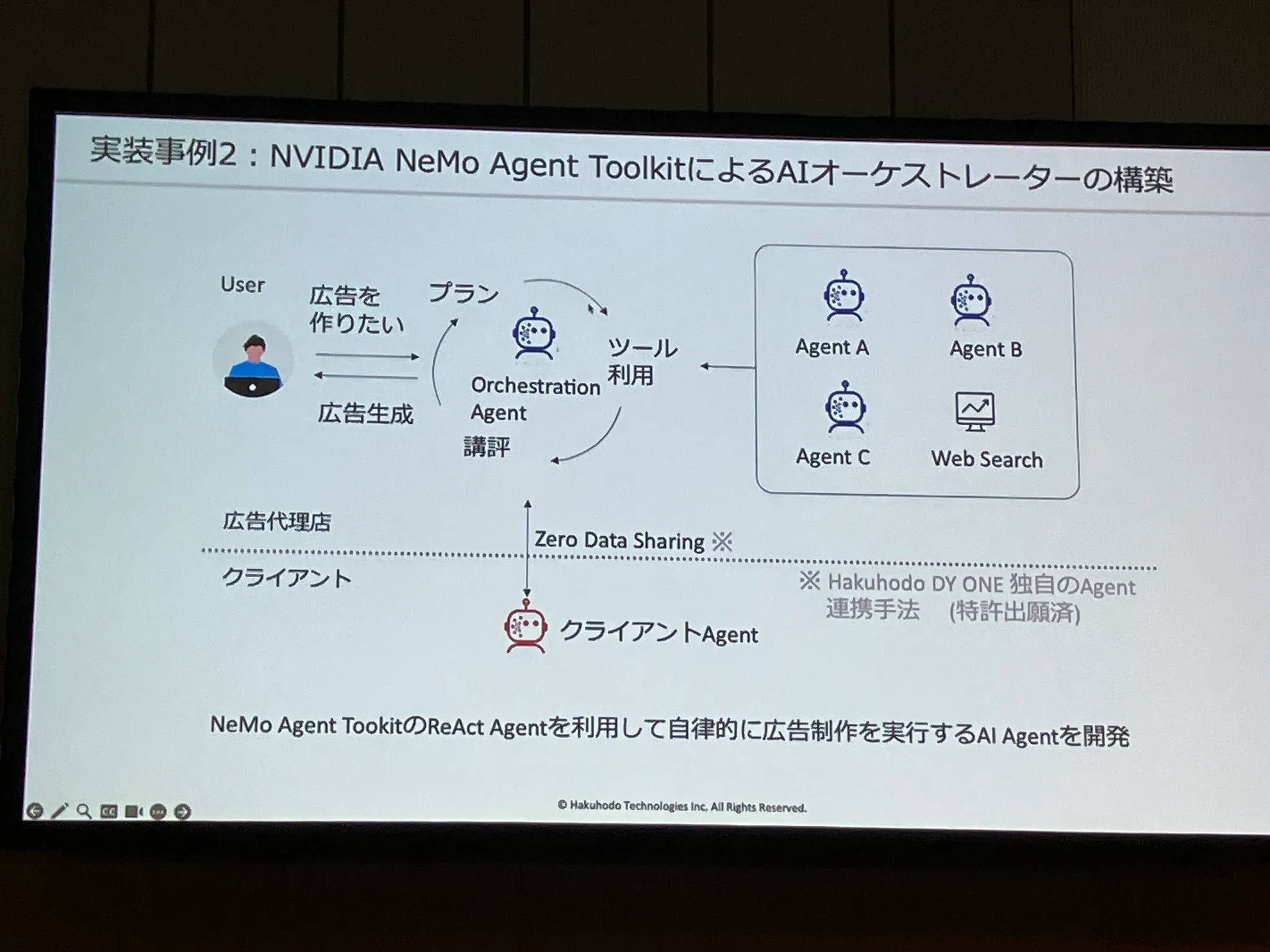

また、NeMo Agent Toolkitを用いて、バーチャル生活者エージェント、効果予測エージェント、コピー制作エージェントなどの専門AIを、自在に連携・制御するAIオーケストレーターの構築も行っています。

このように専門化されたエージェント同士を結合することで、エージェントAIが担う業務範囲がどんどん広がっていきそうですね 🤔

このセッションは、NVIDIAからの技術紹介を先に聞いて、実際に使っている企業からの事例紹介という流れでしたが、最先端技術を活用した身近な事例があると、想像がつきやすくて、とても分かりやすいなと思いました 💡

リーズニング時代におけるスケーラブルな AI 推論プラットフォーム実現手法

最近、単に推論するだけではなく、論理的思考を経て結論を導くリーズニングモデルと、そのリーズニングを用いて、より複雑なタスクを解決できるAIエージェントの需要が高まっています。

それに伴い、以前と比較して、より大きなモデル、より長い思考時間、より大きなコンテキストが求められ、推論に必要な計算要件は増大しています 📈

そこで、 NVIDIA Dynamo という大規模なリーズニングに向けたAI推論のためのフレームワークが開発されました。

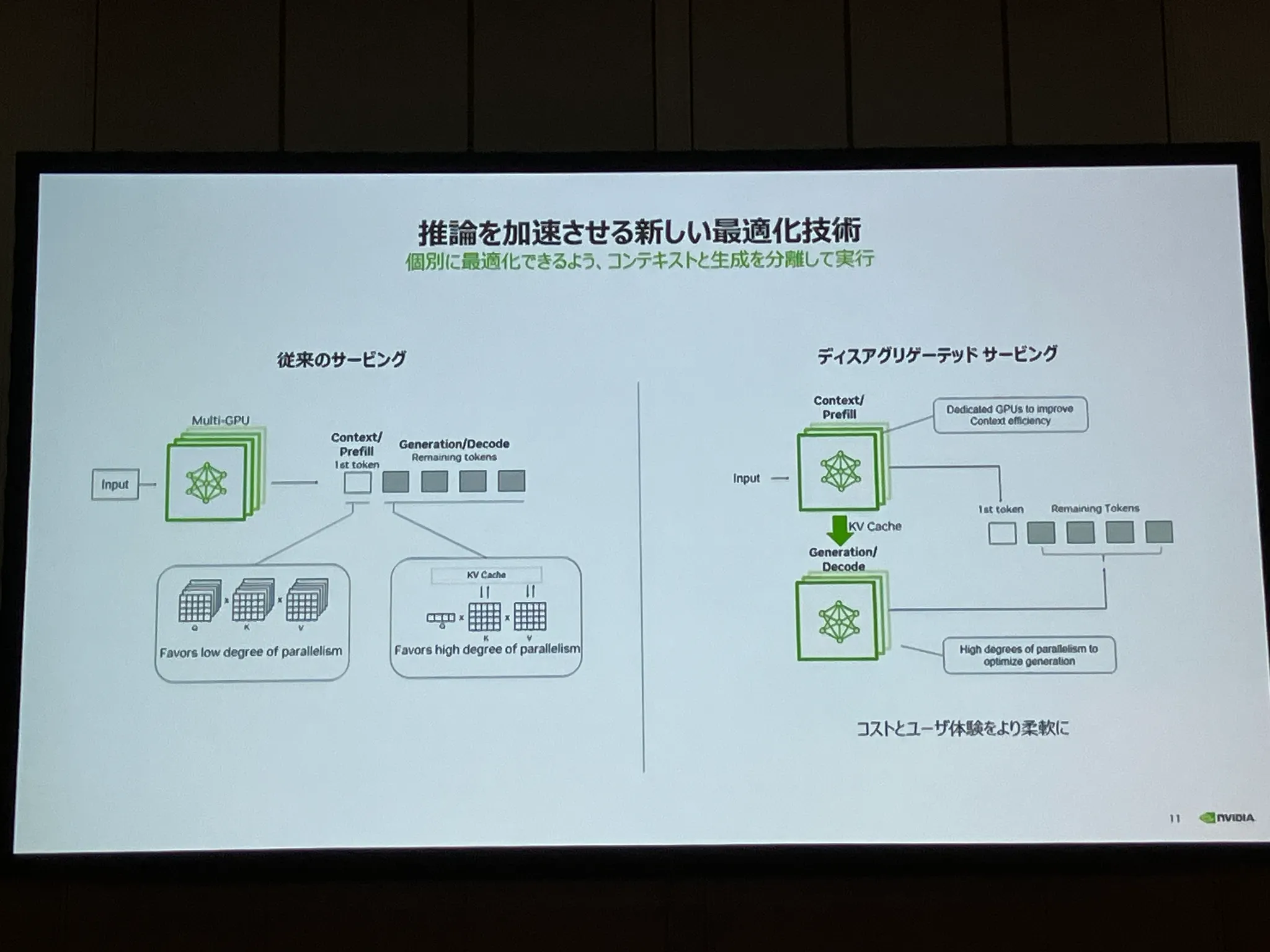

Dynamoは、 Prefill(プロンプト処理の部分) と Decode(トークン生成の部分) を混在させると応答が遅くなるという従来の問題を、個別に最適化できるように分離して実行させる ディスアグリゲーテッドサービング という技術で解決しています。

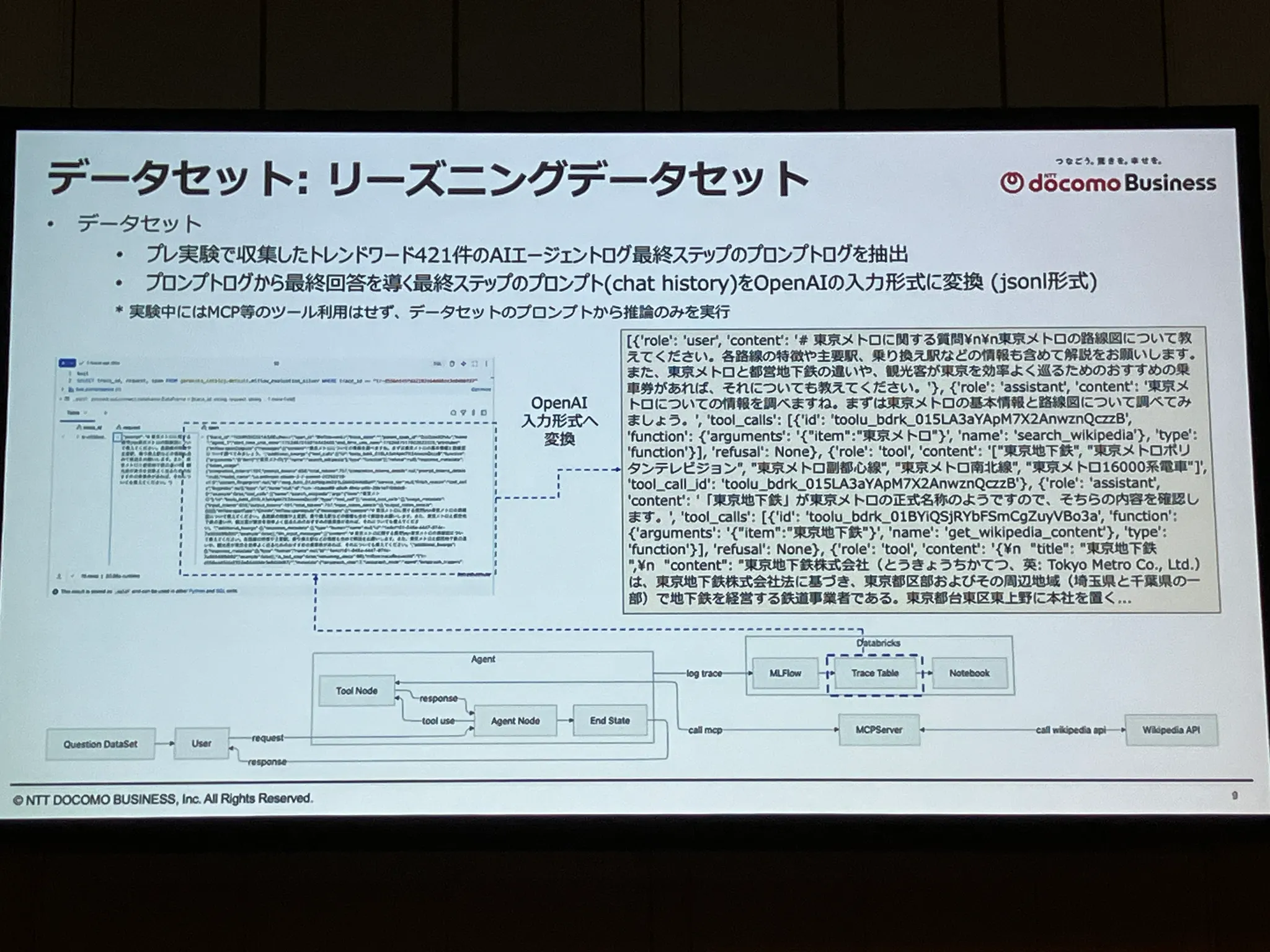

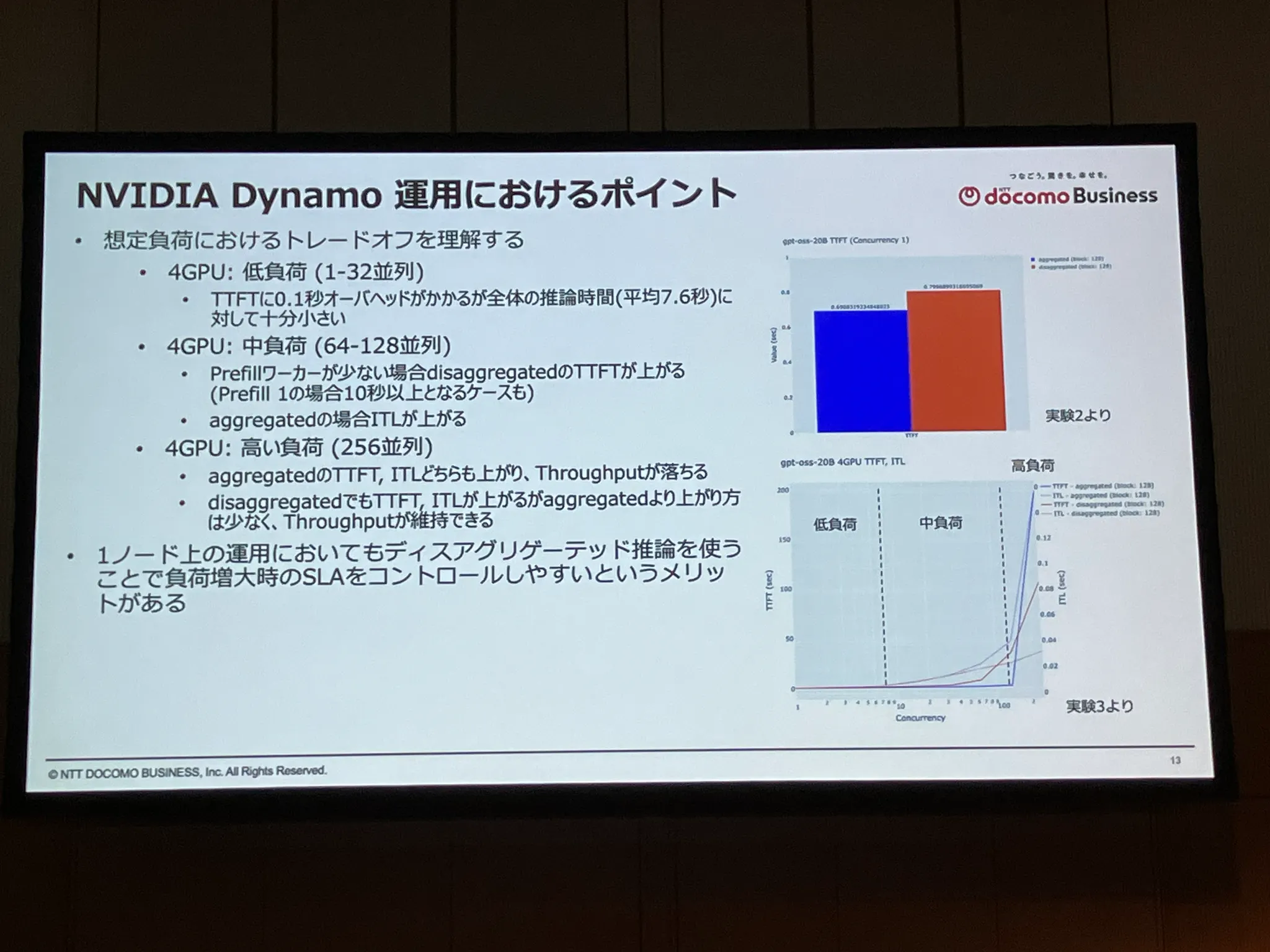

NTTドコモビジネスは、AIエージェントのプロンプトログを抽出したデータセットを作成し、NVIDIA Dynamoに搭載された ディスアグリゲーテッドサービング が実際のユースケースでどれぐらい有効かの実験を行い、その内容を発表していました。

リクエスト開始から、1つ目のトークンが生成されるまでの時間である TTFT(Time To First Token) と、各トークン生成間の時間である ITL(Inter-Token Latency) を、負荷を変えて計測し、特に負荷増大時において、安定化が図れる仕組みになっていることを実証したとのことです。

新技術の利点と欠点を理解した上で、運用に取り入れるというのは大事なことだと思います。

特に、AIエージェントのプロンプトログという、大きなコンテキストを想定したデータセットを作成し、実験を行っていて凄いなと思いました。

「大規模に使えるんだ」という技術の理解で止まらず、「実際にどういう使い方をされるのか?」を想定した実験を行っているのが素晴らしいですね 🔬

まとめ

たくさんのセッションを聴講し、難しい内容もありましたが、最先端のAIについて学ぶことができました。

特に、エージェント型AI、フィジカルAIと、AIの進化により、どんどん計算コストが高くなってきている中で、NVIDIA、またNVIDIA製品を活用している企業がどのように立ち回っているのかについても知ることができてよかったです。

個人的には、今までクラウドサービスのことを聞く機会の方が多く、GPUの中身について詳しく聞く機会がなかったので、とても新鮮に感じました 📝

NVIDIA On-Demandで、アーカイブ公開中なので、興味がある方は、ぜひご覧ください。

https://www.nvidia.com/ja-jp/ai-days/

NVIDIA Developer Program に登録している参加者は、お土産にNVIDIAノベルティをもらえました。

私はオリジナルキャップをもらいました!

次回の NVIDIA AI Day 、かぶって行きます!